Google Research ha lanzado Atlas: leyes prácticas de escalado para modelos multilingües, un avance que no debemos ignorar. No es solo un documento técnico; es una guía concreta para entender cómo escalar eficientemente los Modelos de Lenguaje Multilingües (MLLMs). Derivadas de una batería de experimentos exhaustivos con Gemma 3, estas leyes trazan una ruta clara entre el rendimiento en traducción y factores como el tamaño del modelo, la inversión computacional en preentrenamiento y la calidad de tus datos específicos por idioma.

Atlas: Leyes de escalado multilingües y sus implicaciones prácticas

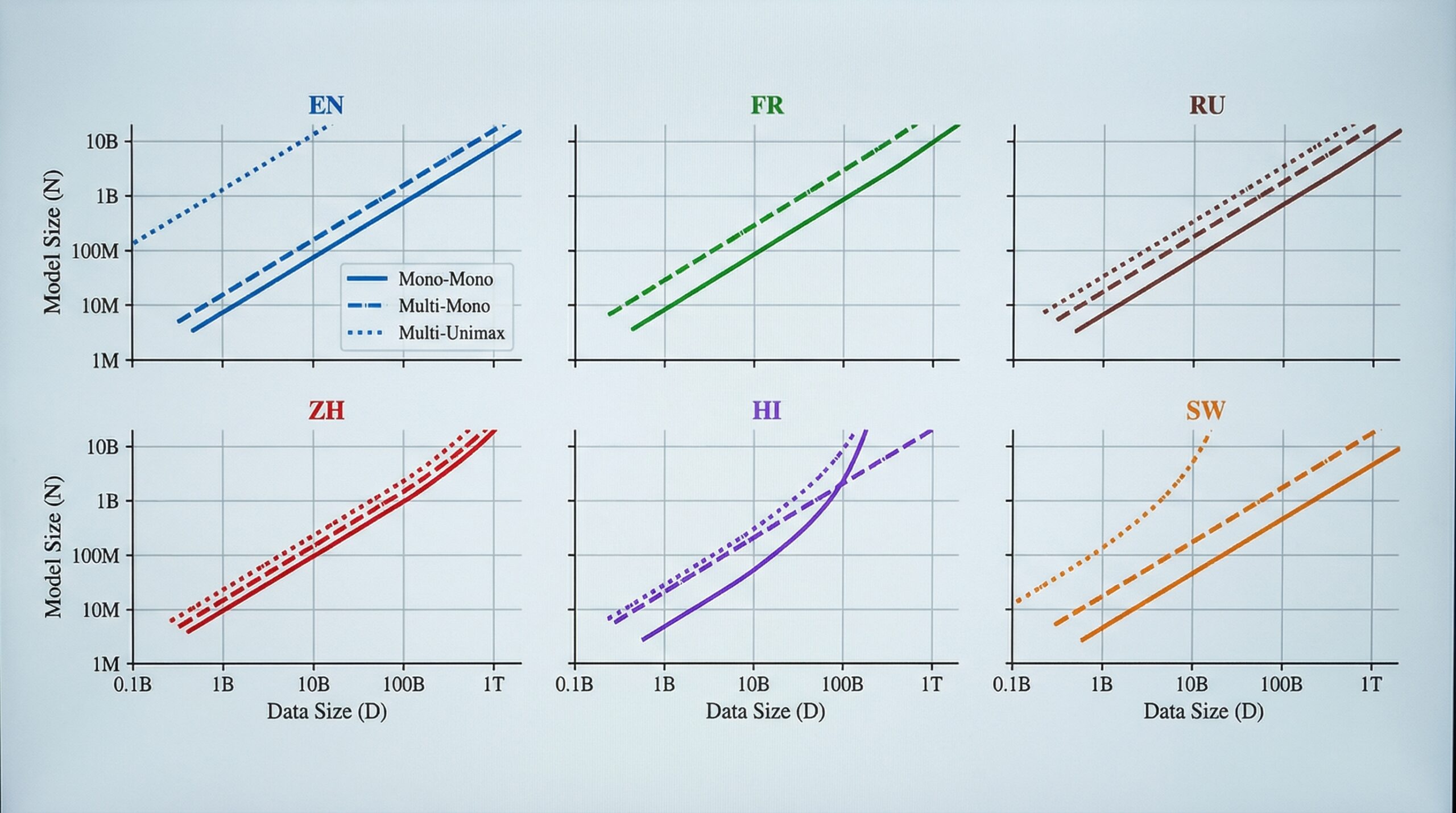

Lo que me interesa de este estudio son las conclusiones directas. Primero, la mejora en el rendimiento, medida por la puntuación BLEU en traducción, escala linealmente con la raíz cuadrada del número de tokens de entrenamiento, especialmente en idiomas con menos recursos. Esto es crucial: significa que los datos de alta calidad —monolingües y paralelos— son el motor real de las capacidades multilingües, no solo la fuerza bruta computacional.

Segundo, el rendimiento sigue una curva de escalado suave con el cómputo total. Esto es mejor que las clásicas leyes de Chinchilla para contextos multilingües. Incluso modelos más grandes (hasta 27B parámetros) siguen mostrando ganancias considerables de rendimiento por cada unidad de cómputo invertida. Es decir, hay espacio para crecer y seguir siendo eficientes.

Tercero, existe una transferencia cruzada de idiomas. Las capacidades desarrolladas en idiomas de alto recurso (inglés-español, por ejemplo) pueden beneficiar a los de bajo recurso, pero la saturación solo se logra con datos específicos. Atlas: leyes prácticas de escalado para modelos multilingües cuantifica este efecto, algo fundamental para planificar tu estrategia de expansión.

Finalmente, Atlas nos da ecuaciones predictivas. ¿Qué significa esto para tu negocio? Que puedes estimar el rendimiento que obtendrás en función de tu presupuesto computacional y la cantidad de datos que tengas. Por ejemplo, para alcanzar un BLEU de 40 en un idioma de rango medio, necesitarás aproximadamente 10 mil millones de tokens específicos para ese idioma, además de un modelo base de 9 mil millones de parámetros. Esto te permite planificar con antelación y optimizar tus inversiones.

Análisis Blixel: Tu estrategia con Atlas: leyes de escalado multilingües

Como Sofía Navarro, mi visión es clara: esto cambia la forma en que las PYMEs deben abordar sus proyectos de IA multilingüe. Olvídate de la idea de que más cómputo siempre es mejor. Google Research con Atlas: leyes prácticas de escalado para modelos multilingües nos dice que la clave está en la eficiencia y la calidad de datos, especialmente si trabajas con idiomas de bajo recurso. Si tu empresa busca expandirse globalmente, la prioridad número uno debe ser la recolección de datos específicos y de alta calidad para cada idioma target.

No se trata de comprar el servidor más potente, sino de optimizar tus recursos. Atlas valida que un balance adecuado entre cómputo del modelo y cantidad de datos (la proporción ideal es 20:1 tokens:parámetros, según las pruebas con Gemma 3 en Vertex AI) maximiza la eficiencia. Esto democratiza el desarrollo multilingüe, ya que no necesitas ser Google para competir. Lo que necesitas es una estrategia sólida de datos y un entendimiento claro de cómo escalar. Planifica tus inversiones en datos antes que en infraestructuras masivas.

Fuente: Google Research