Un juguete IA expone logs chats infantiles a cualquier usuario con cuenta de Gmail, revelando unos 50.000 registros de conversaciones de niños. Según Wired, la brecha radicaba en un endpoint de API público sin autenticación, permitiendo acceso a datos sensibles como nombres reales y contextos personales. Este incidente pone en jaque la seguridad en dispositivos IA para menores, donde regulaciones como COPPA en EE.UU. y GDPR en Europa exigen protección estricta de datos infantiles.

Detalles de la vulnerabilidad técnica

La falla se originó en un servidor cloud mal configurado, con una API REST expuesta sin verificación de credenciales como JWT o OAuth. Cualquier consulta HTTP simple devolvía logs detallados, sin cifrado end-to-end ni anonimización. Esto viola principios básicos de seguridad, como rate limiting o IP whitelisting, facilitando el scraping masivo de datos. La empresa parcheó el problema tras la detección, pero el daño ya estaba hecho: miles de interacciones infantiles accesibles públicamente durante semanas.

Los logs incluían patrones de uso del agente conversacional, revelando no solo chats sino hábitos y preferencias de niños, datos valiosos para perfiles de IA pero prohibidos sin consentimiento parental bajo COPPA.

Riesgos éticos y regulatorios

Este juguete IA expone logs chats infantiles a amenazas como grooming, doxxing o uso no consentido en entrenamiento de modelos. En Europa, el GDPR impone DPIA (evaluaciones de impacto en privacidad) para datos de menores, con multas hasta 4% de facturación global. En EE.UU., COPPA exige verificación parental para recolección de datos, y este caso podría atraer investigaciones de la FTC. La ironía: mientras reguladores aprietan con normas como la AI Act, fallos básicos de diseño persisten en startups ansiosas por innovar.

Precedentes como el escándalo de Cambridge Analytica muestran cómo datos vulnerables alimentan abusos, pero aquí el foco es infantil, amplificando la gravedad.

Respuestas y lecciones para la industria

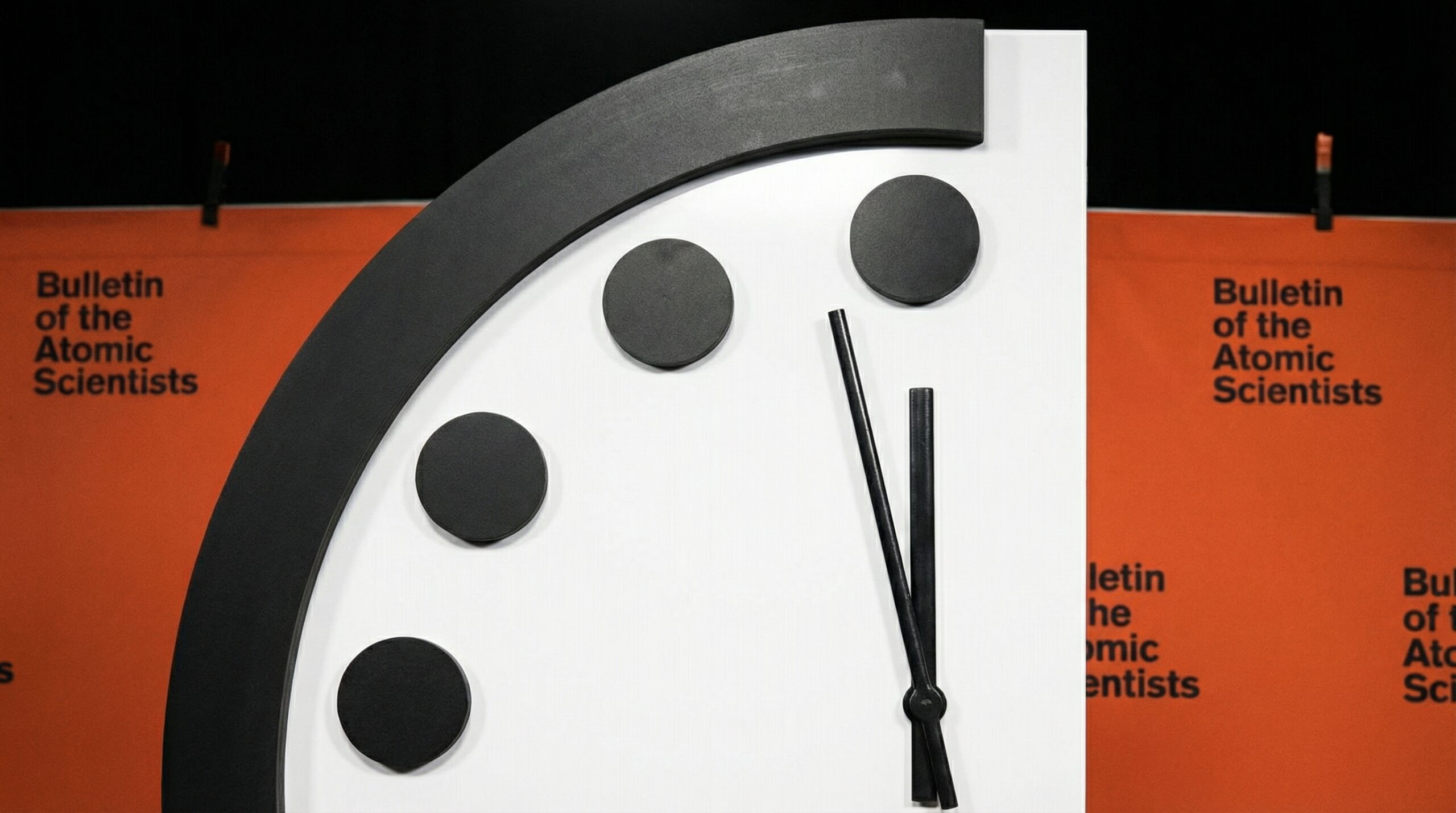

La compañía reconoció el error y aplicó parches, pero no detalló compensaciones a usuarios. Expertos recomiendan arquitecturas zero-trust, pseudonymización y herramientas como AWS GuardDuty para monitoreo. En un mercado de juguetes IA en auge –valorado en miles de millones–, este incidente subraya que la innovación no excusa negligencia.

Reacciones de la industria incluyen llamadas a auditorías proactivas, alineadas con Privacy by Design, sin caer en sobrerregulación que frene el desarrollo de IA educativa para niños.

Análisis Blixel:

Como redactor escéptico de narrativas corporativas, este caso de juguete IA que expone logs chats infantiles no es solo un fallo técnico, sino un recordatorio brutal de que la prisa por monetizar datos en IA infantil ignora riesgos reales. No caigamos en pánico regulatorio: COPPA y GDPR ya proveen marcos sólidos, pero ejecutarlos requiere disciplina, no más leyes. La verdadera hipocresía está en empresas que pregonan ‘IA segura para niños’ mientras dejan APIs abiertas como puertas traseras. Datos duros: según informes de OWASP, el 90% de brechas en IoT provienen de configuraciones deficientes, no de hackers sofisticados. Solución pragmática: adoptar zero-trust y logging mínimo viable desde el diseño, liberando innovación sin sacrificar privacidad. Si sobrerregulación asfixia startups, fallos como este matan la confianza pública. El futuro pasa por equilibrar: auditar, pero no censurar el potencial educativo de la IA para generaciones digitales. Sin evidencia de malas intenciones aquí, solo incompetencia evitable.