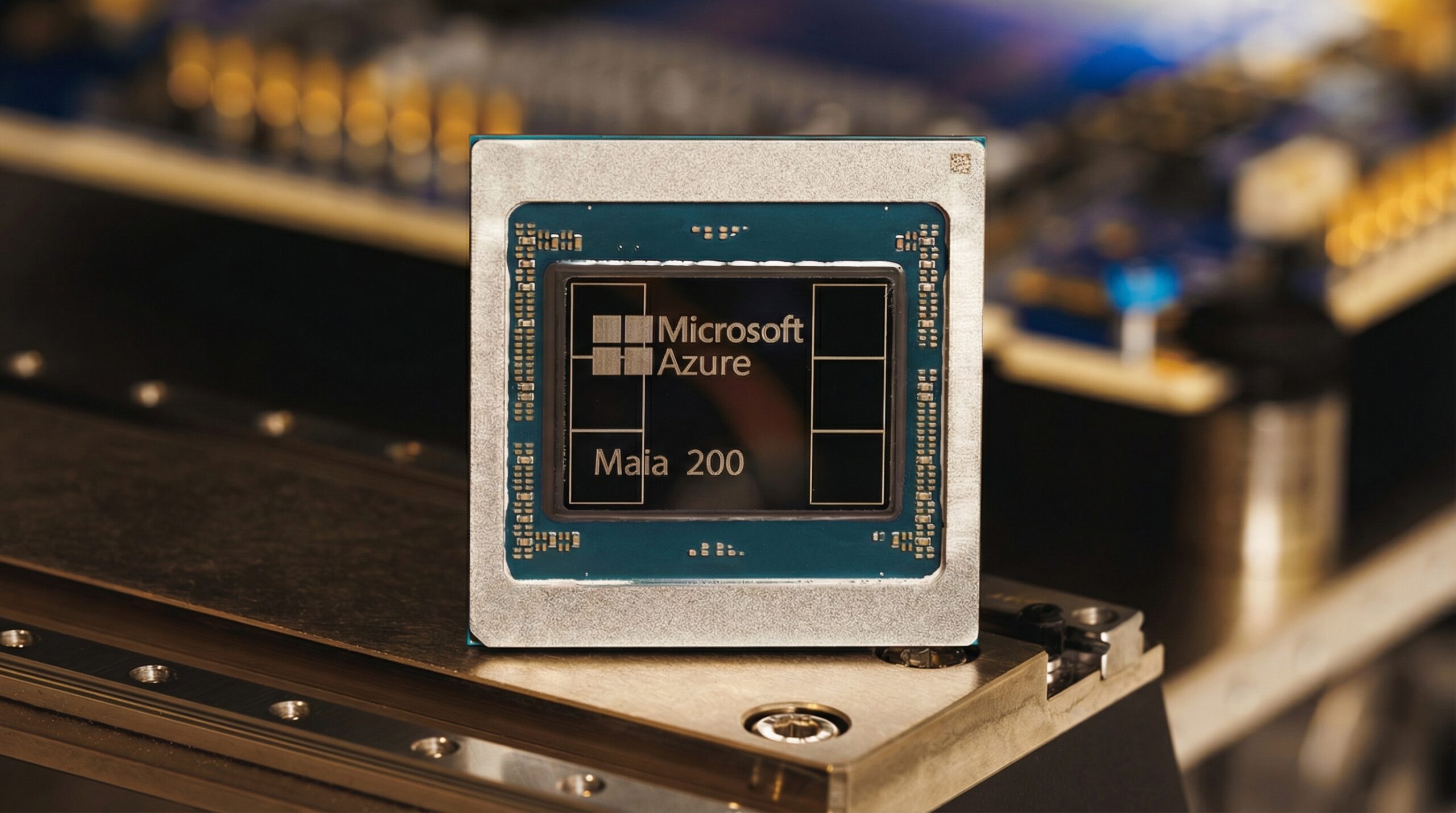

El Microsoft retrasa chip Maia Braga es un golpe inesperado para la hoja de ruta de la compañía en hardware de IA. Originalmente previsto para producción en masa en 2025, el chip codename Braga, ahora renombrado Maia 200, se aplaza al menos seis meses hasta 2026. Causas: cambios de diseño impulsados por OpenAI que desestabilizaron simulaciones, escasez de personal y alta rotación. Este setback cuestiona la capacidad de Microsoft para competir en custom silicon frente al dominio de Nvidia.

Detalles del retraso en Maia Braga

Microsoft planeaba implementar Maia 200 en datacenters este año, pero problemas técnicos han forzado el aplazamiento. Fuentes internas revelan que adiciones solicitadas por OpenAI para optimizar inferencia IA generaron inestabilidad en pruebas de simulación. Además, limitaciones de staffing agravan el panorama en un sector con talento escaso. El chip se centra en inferencia, no entrenamiento –un enfoque pragmático–, alineado con la roadmap: Maia 200 (2026), Braga-R (2026) y Clea (2027). Un chip de entrenamiento fue cancelado en 2024, priorizando eficiencia operativa.

Maia 100, lanzado en 2023 para procesamiento de imágenes pre-ChatGPT, se limita a training interno y no impulsa servicios productivos. Este historial resalta la curva de aprendizaje en diseño de ASICs para IA, donde iteraciones rápidas chocan con complejidad técnica.

Impacto competitivo frente a Nvidia

El Microsoft retrasa chip Maia Braga amplía la brecha con Nvidia, cuyo Blackwell –lanzado el año pasado– establece el estándar en rendimiento. Fuentes indican que Maia 200 quedará ‘muy por detrás’, frustrando el objetivo de reducir dependencia de GPUs Nvidia, que dominan el 80-90% del mercado de datacenters IA según datos de mercado. Hyperscalers como Google (TPUs) y Amazon (Trainium3) avanzan en custom silicon, pero Microsoft enfrenta dudas sobre su roadmap hasta Maia 300 (Clea), con diseño radicalmente nuevo.

Costos de Nvidia escalan: un clúster Blackwell supera los cientos de millones. Custom chips prometen ahorro del 30-50% en TCO, pero delays erosionan esa ventaja estratégica.

Desafíos técnicos en custom silicon IA

El retraso evidencia riesgos inherentes: diseño iterativo para workloads específicos como inferencia genera inestabilidad si no se calibra staffing. Rotación alta en ingenieros de silicio –competencia feroz por talento– es endémica. Microsoft declinó comentar, pero precedentes como delays en Apple M-series o Intel Gaudi ilustran que incluso gigantes tropiezan en la carrera IA.

En un campo de evolución exponencial, donde Moore’s Law se acelera por IA, estos setbacks frenan innovación. Sin embargo, persiste el incentivo: hyperscalers gastaron $100B+ en capex IA en 2025, impulsando autosuficiencia hardware.

Análisis Blixel:

Como escéptico de narrativas corporativas, veo en el Microsoft retrasa chip Maia Braga no un fracaso aislado, sino síntoma de hipérboles en la carrera armamentística IA. Microsoft apuesta por inferencia custom para esquivar el peaje Nvidia –lógico, dados datos: GPUs Blackwell consumen 1MW+ por rack, con márgenes del 70% para Jensen Huang. Pero ¿es viable? OpenAI, socio clave, pide features que rompen simulaciones; ironía, cuando Sam Altman critica ‘costos insostenibles’ de compute.

Datos duros: mercado custom silicon IA crecerá a $50B para 2028 (Gartner), pero Nvidia retiene 85% share por ecosistema CUDA. Microsoft, con Azure AI, necesita Maia para márgenes competitivos, no solo balanza geopolítica contra chips taiwaneses. Retrasos como este –sextos meses– son norma: Google TPU v5 tardó un año extra. Lección: innovación real exige paciencia, no roadmaps de PowerPoint. Si Clea 2027 entrega, genial; si no, Microsoft quedará anclado en renta Nvidia. Prioricemos talento sobre hype: atraer 1.000 ingenieros silicio no es trivial en guerra de salarios. Futuro: diversificación gana, monopolios pierden. Pro-innovación, sí; pero con realismo.

Deja una respuesta