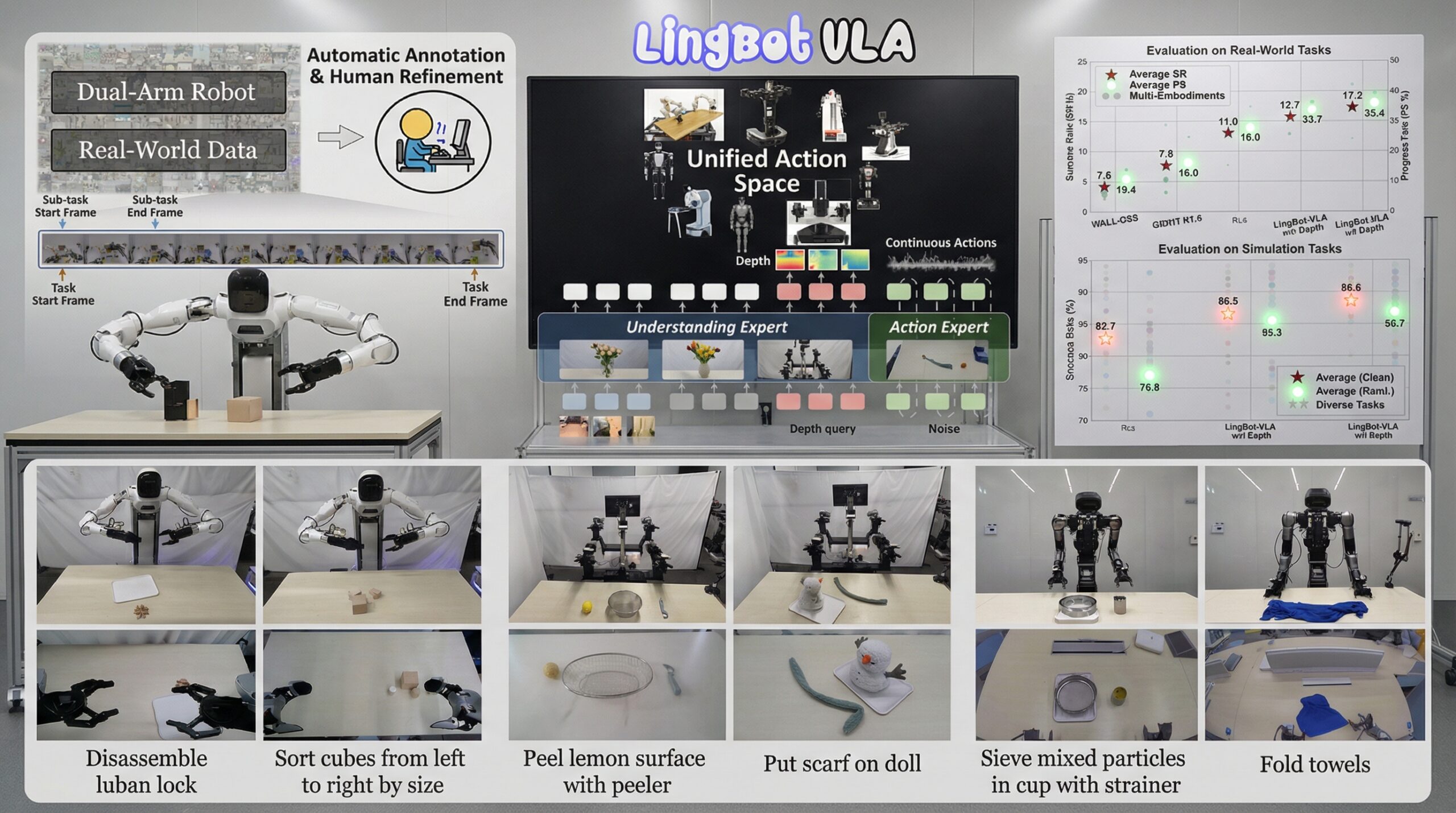

El Instituto Allen para IA (AI2) ha dado un paso firme hacia la democratización del desarrollo de software asistido por IA, presentando AI2 lanza SERA (Soft-verified Efficient Repository Agents). Este no es solo otro modelo, es la primera pieza de su serie Open Coding Agents, y lo más relevante: es un agente de codificación de 32B parámetros completamente open-source. Esto significa que los datos, métodos y el propio código están disponibles para todos, marcando un antes y un después en cómo las PYMEs y desarrolladores independientes pueden acceder a herramientas de vanguardia.

AI2 lanza SERA: Rendimiento de élite a coste reducido

SERA no es un modelo cualquiera; alcanza resultados state-of-the-art en benchmarks exigentes como SWE-bench Verified, logrando un 54.2% de éxito en un contexto de 64K. Esto lo posiciona por delante de modelos open-source comparables como Qwen3-Coder y lo iguala a soluciones cerradas de grandes ligas como Devstral-Small-2 de Mistral. Pero lo verdaderamente revolucionario es cómo lo logra.

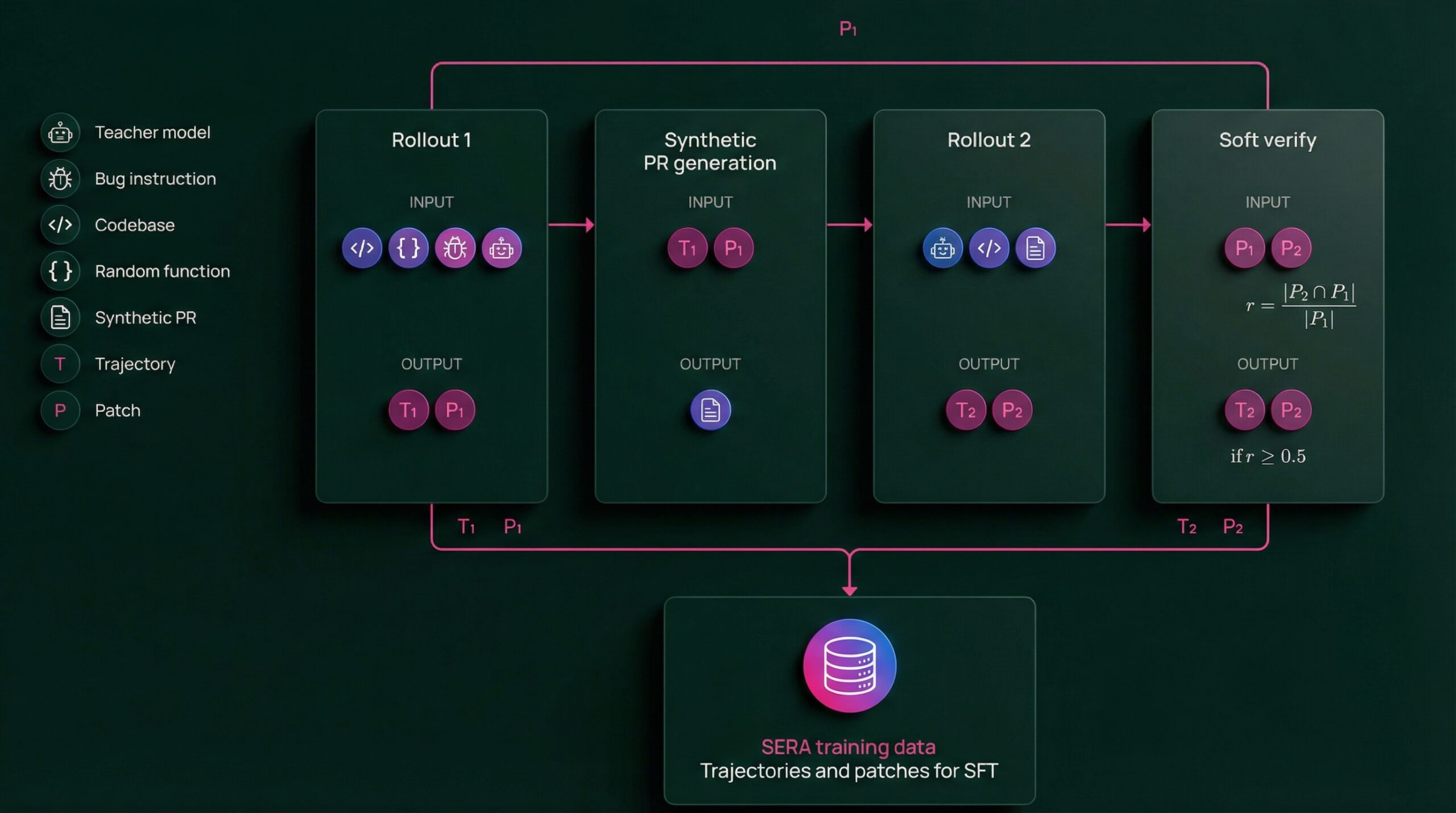

La clave reside en su método Soft Verified Generation (SVG), que genera miles de trayectorias sintéticas a partir de un solo repositorio. A diferencia de la verificación ‘hard’ (ejecución completa de tests), SVG utiliza una verificación ‘soft’ —una simple coincidencia parcial línea por línea— para validar el código. Esto reduce drásticamente los costos de entrenamiento. Entrenar SERA cuesta apenas 40 días-GPU, lo que se traduce en aproximadamente 2000 dólares. Hablamos de una eficiencia 26 veces superior a los métodos basados en Reinforcement Learning (RL) y 57 veces más barata que las técnicas previas de datos sintéticos con un rendimiento equivalente.

Análisis Blixel: La oportunidad inminente para tu empresa

Desde Blixel, vemos con claridad el impacto de que AI2 lanza SERA. Para las PYMEs, esto es una noticia excelente. La barrera de entrada para usar agentes de codificación avanzados era el coste y la necesidad de modelos genéricos que a menudo fallaban al adaptarse a la lógica interna de repositorios específicos. SERA, con su enfoque en repositorios privados y su capacidad para crear agentes adaptados a tu base de código, rompe este paradigma.

Ya no necesitarás una inversión millonaria para tener un asistente de código especializado en tu propia arquitectura. La liberación de más de 200.000 trayectorias sintéticas, junto con el código y los datos, significa que puedes empezar a experimentar y adaptar estos agentes a tus necesidades de forma mucho más ágil y económica. Si estás pensando en optimizar tus procesos de desarrollo de software, o incluso necesitas una IA que entienda las peculiaridades de tu código para tareas de mantenimiento o nuevas implementaciones, SERA te ofrece una vía práctica y accesible. Los análisis demuestran que esta verificación ‘soft’ genera datos de igual o superior calidad con un escalado lineal, lo que simplifica la complejidad de los pipelines tradicionales.

SERA utiliza exclusivamente Supervised Fine-Tuning (SFT), sin recurrir al RL, un dato importante. Esto demuestra que un modelo unificado puede gestionar un flujo de trabajo completo –desde la búsqueda y edición hasta la resolución de problemas–, superando la eficacia de arquitecturas más especializadas y costosas. Esto es un game-changer para las empresas medianas que buscan optimizar sus ciclos de desarrollo.

El Instituto Allen para IA no solo publicó SERA, sino que también liberó la mayor base de datos open-source para agentes de codificación, integrándola incluso con Claude Code. Esto no solo democratiza el acceso a tecnología punta, sino que también valida una idea crucial: la especialización a nivel de repositorio es práctica, eficiente y, a menudo, superior al entrenamiento genérico.

Fuente: Marktechpost